Por qué el punto 8.4 no debería figurar en el orden del día aprobado

He evitado pronunciarme sobre este tema, pero el punto 8.4 del orden del día no deja lugar al silencio. Es hora de hablar sobre la seguridad de las multitudes, ForceMetrics y la continua expansión de la inteligencia artificial en la policía del distrito 2, Sparks y más allá.

El punto 8.4 del orden del día figura en el orden del día aprobado para la reunión del Ayuntamiento de Sparks del 12 de enero de 2026, y eso es importante. Los puntos del orden del día aprobado (8.1, 8.2, 8.3 y 8.4) no se debaten individualmente. Se agrupan y se aprueban en una sola votación. A menos que un concejal retire un punto para su consideración por separado, todos ellos se aprueban sin debate.

Asuntos rutinarios y administrativos: ese es el papel que desempeña el orden del día consensuado en el procedimiento parlamentario.

El punto 8.4 no es eso.

A primera vista, el punto 8.4 parece ser una votación de procedimiento para aceptar una subvención de 66 360,00 dólares para tecnología policial, y en sentido estricto, así es. Pero lo que me plantea un problema es la tecnología específica que se implementaría en Sparks como resultado de esa votación: ForceMetrics.

Captura de pantalla de la cláusula sobre aprendizaje automático de ForceMetrics en su contrato propuesto con la ciudad de Sparks.

ForceMetrics es una plataforma que utiliza IA tanto no generativa como generativa para agregar datos de múltiples fuentes y presentarlos a los equipos de primera respuesta. A primera vista, parece algo positivo. Conecta sistemas como el Centro de Información en Tiempo Real (RTIC), las cámaras de seguridad Flock —volveré sobre Flock más adelante— y otras bases de datos. A simple vista, todo parece maravilloso.

Captura de pantalla de la página de inicio de ForceMetrics, tomada el 8 de enero de 2025.

La ciudad de Reno y el Departamento de Policía de Reno ya utilizan este producto.

Este hecho ayuda a contextualizar lo que ocurrió en septiembre de 2023, cuando un agente de policía de Reno confió ciegamente en un software de reconocimiento facial basado en inteligencia artificial en un casino local y desestimó el documento de identidad Real ID expedido por Nevada, las tarjetas de crédito, las nóminas y otros documentos de un camionero, arrestándolo y deteniéndolo injustamente durante más de 11 horas.

El hombre que fue arrestado injustamente ha llegado a un acuerdo con el casino y ahora está demandando a la ciudad de Reno, al Departamento de Policía de Reno y al agente que lo arrestó por violar sus derechos constitucionales recogidos en la Cuarta Enmienda. Incluso si la ciudad finalmente gana el juicio, la defensa de esa demanda le costará a Reno una cantidad considerable de dinero público.

Captura de pantalla de una sección del sitio web de ForceMetrics, tomada el 7 de enero de 2025.

Esto pone de relieve uno de los principales argumentos de venta de estos sistemas de IA —y de ForceMetrics en concreto—: una mayor conciencia situacional. Pero, ¿qué ocurre cuando el sistema se equivoca? ¿Qué ocurre cuando los agentes confían demasiado en lo que les dice el sistema?

Una persona inocente puede ser tratada como un delincuente violento, e incluso un documento de identidad real de Nevada puede no ser suficiente para resolver el asunto porque «así lo dice la IA». Por otro lado, ¿qué pasa si el sistema pasa algo por alto y tranquiliza falsamente a un agente cuando se requiere una mayor precaución?

Ese es el riesgo que entrañan estos sistemas. Cuando se utilizan como herramientas de asesoramiento, pueden facilitar el trabajo y hacerlo más seguro. Cuando se consideran autoritarios, pueden amplificar los errores humanos. Ya hemos visto este patrón en todos los sectores, sobre todo en los fallos de los coches autónomos o incluso en los accidentes del 737 Max en 2018 y 2019, y la policía no es un ámbito en el que podamos permitirnos ese tipo de errores.

Captura de pantalla de una sección del sitio web de ForceMetrics, tomada el 7 de enero de 2025.

Volviendo al punto 8.4, relativo a la aceptación de 66 360,00 dólares para pagar ForceMetrics, es importante señalar que se trata de una suscripción de software. ¿Qué pasará el año que viene? ¿O el año siguiente? Una vez que los agentes hayan recibido formación al respecto y los flujos de trabajo dependan de él, ¿qué pasará si no se renueva la subvención? ¿Se convertirá simplemente en otra responsabilidad anual de 66 360,00 dólares que se espera que asuma la ciudad de Sparks?

Ya he mencionado anteriormente las cámaras Flock Safety, y si me conocéis, sabéis que son uno de los productos que menos me gustan, y no solo por lo que hacen. Las cámaras Flock Safety son lectores automáticos de matrículas (ALPR) que se alquilan a las ciudades por unos 5000 dólares al año por cámara, más los gastos adicionales de instalación y mantenimiento. Sparks tiene actualmente 45 de estas cámaras instaladas, operadas por Flock Safety en nombre del Departamento de Policía de Sparks.

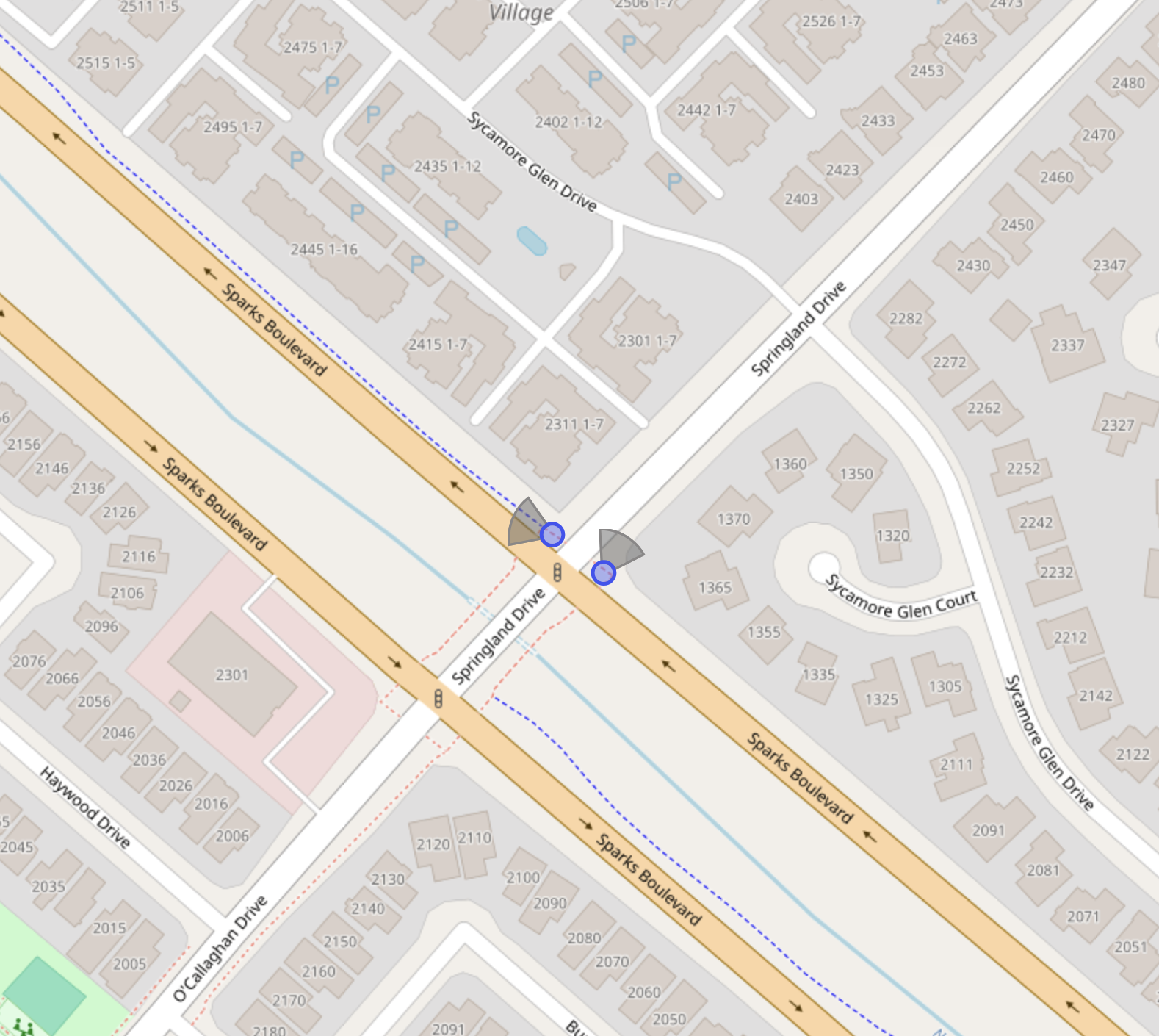

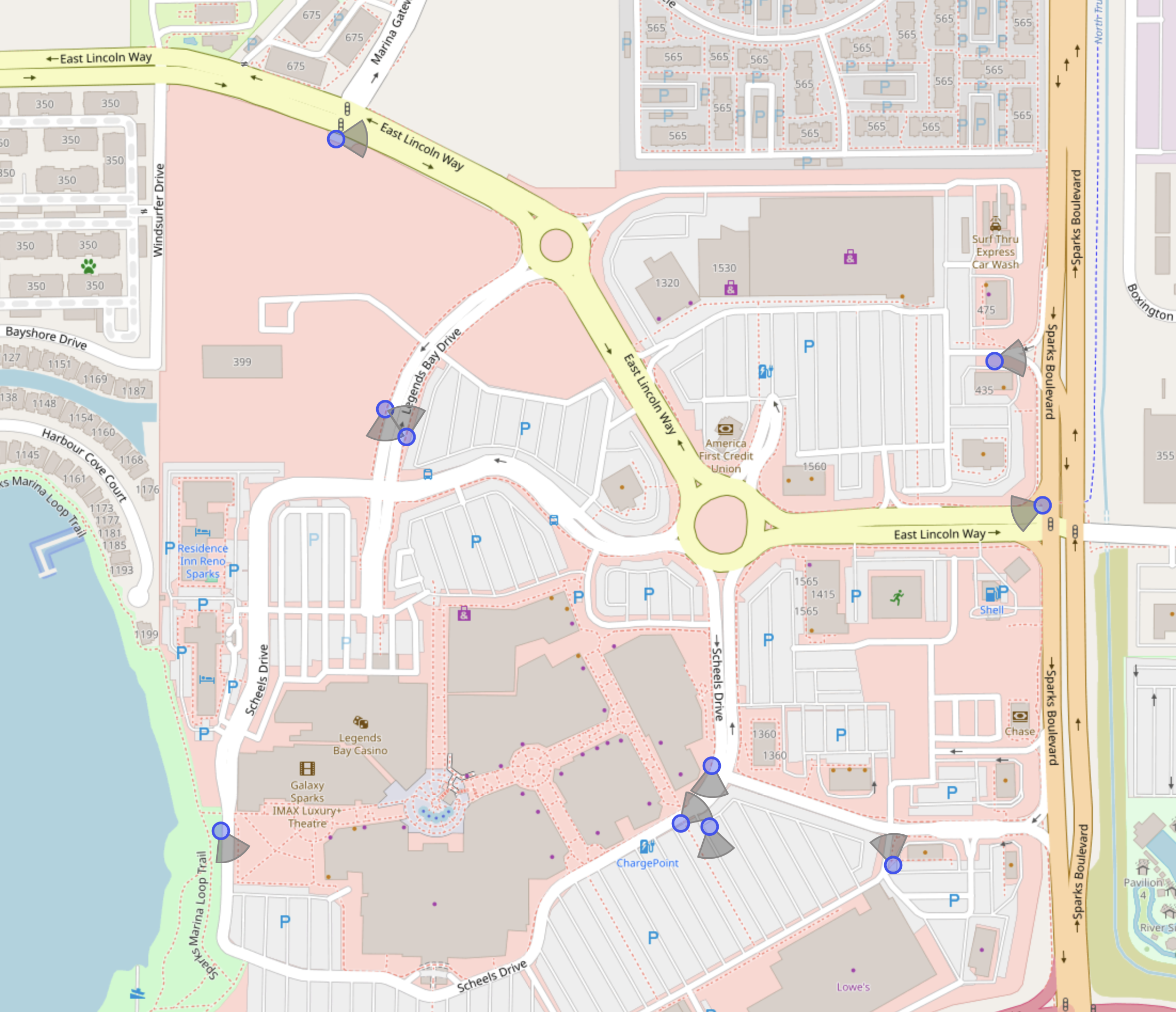

Estas cámaras se colocan en lugares estratégicos para que la red pueda determinar por qué zonas o partes de la ciudad circula un vehículo. El objetivo declarado es ayudar en las investigaciones criminales. Por ejemplo, hay muchas cámaras situadas alrededor del centro comercial Legends Mall: es casi imposible aparcar allí sin pasar por delante de una. Si se produce un robo en una tienda, la policía puede disponer de una imagen del sospechoso tomada en la tienda y, a continuación, consultar la red de cámaras para ver qué vehículos se encontraban en la zona.

Tengo múltiples críticas hacia Flock Safety, sus cámaras y el funcionamiento de su red.

Cuando se instalan suficientes cámaras y se vuelven inevitables, dejan de ser una herramienta para comprobar si un vehículo se encontraba en un lugar específico. Se convierten en un sistema capaz de crear registros detallados de los desplazamientos. No se trata de una vigilancia dirigida a un sospechoso concreto, sino de una vigilancia masiva de todos los habitantes de Sparks, las 24 horas del día, los 7 días de la semana, independientemente de si son sospechosos de haber cometido un delito. Su historial de desplazamientos, cada vez que pasa por una de estas cámaras, se almacena en una base de datos en la que se pueden realizar búsquedas.

Si un vehículo no tiene matrícula, Flock Safety utiliza inteligencia artificial para identificar otras características, lo que la empresa denomina «huella digital del vehículo». Creo que este nivel de vigilancia, a esta escala, viola nuestros derechos recogidos en la Cuarta Enmienda.

No se trata de una escuela o una empresa privada que controla quién entra en sus instalaciones. Se trata de un gobierno municipal y un departamento de policía que contratan a una empresa privada para instalar cámaras en lugares inevitables de toda la ciudad. Hasta tal punto que, con una consulta experta de la base de datos, creo que el Departamento de Policía de Sparks y la ciudad de Sparks podrían identificar casi todos los vehículos que se encuentran actualmente dentro de los límites de la ciudad, con un margen de error del 15 % o menos.

¿Por qué centrarse en Flock Safety? Hay otros fabricantes de ALPR: Reno, por ejemplo, ha instalado unidades de Motorola. Pero Sparks utiliza cámaras de Flock Safety. Más allá de mi convicción de que esta vigilancia viola la Cuarta Enmienda, también creo que Flock Safety no es un buen socio ni una empresa ética.

Flock Safety tiene un historial público documentado de prácticas deficientes en materia de ciberseguridad, incluyendo incidentes en los que se expusieron claves API confidenciales, lo que permitió a personas no autorizadas acceder a información confidencial, incluida la ubicación en tiempo real de los agentes de policía. La responsabilidad que conlleva la recopilación y el almacenamiento de estos datos es inmensa. ¿Y para qué beneficio?

Una cámara de seguridad Flock en Legends, Sparks, fotografiada en 2025.

Cuando periodistas, denunciantes y críticos han expresado su preocupación, Flock Safety ha respondido con demasiada frecuencia no con transparencia o medidas correctivas, sino con hostilidad, incluyendo a su director ejecutivo, que se refirió a Defleck como una«organización terrorista». Esa respuesta por sí sola debería preocupar a cualquier ciudad que confíe a esta empresa datos sensibles sobre sus residentes y las fuerzas del orden.

Esta no es una empresa con la que la ciudad de Sparks o el Departamento de Policía de Sparks deberían hacer negocios.

Flock Safety también ha hecho afirmaciones exageradas sobre su eficacia. En un momento dado, la empresa afirmó que sus cámaras ayudaron a resolver el 10 % de todos los delitos cometidos en Estados Unidos, una afirmación que posteriormente fue desmentida y discretamente eliminada de la página de inicio de su sitio web. En otros casos, Flock ha afirmado que se ha producido una reducción de la delincuencia en comunidades específicas en las que los datos muestran que la delincuencia ya estaba disminuyendo antes de que se instalaran las cámaras.

Captura de pantalla del sitio web de Flock Safety.

Estas cámaras incluso se han citado como posibles soluciones para delitos específicos. En una reunión a la que fui invitado a hablar, un concejal actual sugirió que las cámaras Flock podrían haber ayudado a resolver el asesinato de Anna Scott. Quizás lo hubieran hecho. Quizás no. Pero según los mapas de despliegue disponibles públicamente, todavía no hay ALPR desplegados en la I-580 cerca de la escena del crimen después de todos estos años. E incluso si los hubiera habido, ¿qué pasaría si se hubiera utilizado un vehículo robado? ¿Qué pasaría si no tuviera matrícula, pegatinas en el parachoques ni características distintivas para que la IA de Flock pudiera «tomar sus huellas dactilares»?

En ese momento, ¿qué estamos comprando realmente? En mi opinión, aproximadamente 300 000 dólares al año en remedios milagrosos.

¿Cómo se relaciona esto con el punto 8.4 del orden del día?

ForceMetrics está diseñado para agregar datos en una única interfaz. Tiene una asociación con Flock Safety, lo que significa que los datos se incluirían. Datos de ShotSpotter, datos del dron de la policía de Sparks desplegado desde el Ayuntamiento, datos de RTIC, datos de llamadas al 911, datos procedentes de Internet y, potencialmente, otras bases de datos que pueden no ser de dominio público.

El alcance exacto de esta integración es importante, y precisamente por eso merece un debate público.

Captura de pantalla de una sección del sitio web de ForceMetrics, tomada el 7 de enero de 2025.

Esta tecnología afectará a todas las respuestas de las fuerzas del orden —y potencialmente a todas las respuestas de emergencia— en el futuro. Afecta a todos los residentes del Distrito 2 y Sparks, así como a cualquiera que visite nuestra ciudad. Las decisiones con un impacto tan amplio no deberían aprobarse sin un debate público.

Tampoco es la primera vez que se implementa una tecnología de IA controvertida a través de la agenda de consentimiento. El 22 de septiembre de 2025, el Ayuntamiento de Sparks votó a favor de firmar un acuerdo de dos años con DeskOfficer, Inc. para implementar un agente de voz con IA en la línea de despacho no urgente del Departamento de Policía de Sparks. La votación se aprobó por unanimidad, sin debate ni discusión, y con una participación pública mínima.

Lo que pido es sencillo. El punto 8.4 debería retirarse del orden del día y posponerse. La ciudad de Sparks debería celebrar reuniones públicas sobre esta tecnología antes de someterla a votación o, como mínimo, presentarla ante el Ayuntamiento para que conste en acta.

La confianza pública en la policía no solo depende de los resultados, sino también de la transparencia, la moderación y la rendición de cuentas. El punto 8.4 merece ese nivel de exigencia.